Modelos básicos

La promesa y los peligros de un gran avance en inteligencia artificial

The Economist

9 de junio de 2022

Imagine una computadora que podría terminar sus oraciones, usando una mejor forma de frase; o use un fragmento de melodía para componer música que suene como si la hubiera escrito usted (aunque nunca lo hubiera hecho); o resuelva un problema creando cientos de líneas de código de computadora, lo que le permite concentrarse en algo aún más difícil. En cierto sentido, esa computadora es simplemente la descendiente de los telares mecánicos y las máquinas de vapor que aceleraron la Revolución Industrial. Pero también pertenece a una nueva clase de máquina, porque capta los símbolos del lenguaje, la música y la programación y los utiliza de formas que parecen creativas. Un poco como un ser humano.

Los » modelos básicos » que pueden hacer estas cosas representan un gran avance en la inteligencia artificial, o IA. Ellos también prometen una revolución, pero esta afectará el trabajo intelectual de alto nivel que la Revolución Industrial nunca tocó. No hay garantías sobre lo que se avecina; después de todo, AI ha tropezado en el pasado. Pero es hora de analizar la promesa y los peligros del próximo gran avance en inteligencia artificial.

Los modelos básicos son el último giro en el » aprendizaje profundo » (dl), una técnica que saltó a la fama hace diez años y ahora domina el campo de la IA. Basándose libremente en la estructura en red de las neuronas del cerebro humano, los sistemas dl se «entrenan» utilizando millones o miles de millones de ejemplos de textos, imágenes o clips de sonido. En los últimos años, el costo inflado, en tiempo y dinero, de entrenar sistemas dl cada vez más grandes había generado preocupaciones de que la técnica estaba llegando a sus límites. Algunos se preocuparon por un “invierno AI”. Pero los modelos de base muestran que la construcción cada vez más grande y más compleja DL de hecho continúa desbloqueando nuevas capacidades cada vez más impresionantes. Nadie sabe dónde está el límite.

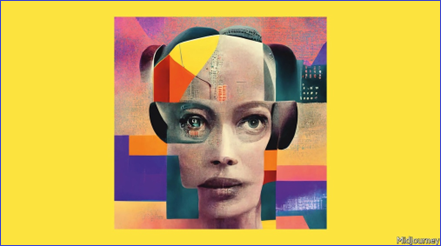

Los modelos resultantes son una nueva forma de inteligencia creativa no humana. Los sistemas son lo suficientemente sofisticados para dominar el lenguaje y también para romper las reglas de manera coherente. Un perro no puede reírse de un chiste del New Yorker, pero un AI puede explicar por qué es divertido, una hazaña que, francamente, a veces está más allá de los lectores del New Yorker . Cuando le pedimos a uno de estos modelos que creara un collage usando el título de este líder y nada más, se nos ocurrió la portada de nuestras ediciones americana y asiática, en la foto (tratamos de distraer a nuestros ansiosos diseñadores humanos con una portada diferente en nuestras ediciones europeas).

Los modelos de base tienen algunas propiedades sorprendentes y útiles. El más inquietante de ellos es su comportamiento “emergente”, es decir, habilidades (como la capacidad de entender un chiste o hacer coincidir una situación y un proverbio) que surgen del tamaño y la profundidad de los modelos, en lugar de ser el resultado de una acción deliberada de diseño. Así como una sucesión rápida de fotografías fijas da la sensación de movimiento, trillones de decisiones computacionales binarias se fusionan en un simulacro de comprensión y creatividad humanas fluidas que, digan lo que digan los filósofos, se parece mucho a la cosa real. Incluso los creadores de estos sistemas se sorprenden de su poder.

Esta inteligencia es amplia y adaptable. Cierto, los modelos básicos son capaces de comportarse como idiotas, pero los humanos también lo son. Si le pregunta a alguien que ganó el premio Nobel de física en 1625, puede sugerir Galileo, Bacon o Kepler, sin entender que el primer premio se otorgó en 1901. Sin embargo, también son adaptables en formas que antes AI. No lo fueron, quizás porque en algún nivel existe una similitud entre las reglas para manipular símbolos en disciplinas tan diferentes como el dibujo, la escritura creativa y la programación informática. Esta amplitud significa que los modelos básicos podrían usarse en muchas aplicaciones, desde ayudar a encontrar nuevos medicamentos utilizando predicciones sobre cómo las proteínas se pliegan en tres dimensiones, hasta seleccionar gráficos interesantes de conjuntos de datos y tratar preguntas abiertas rastreando enormes bases de datos para formular respuestas que abrir nuevas áreas de investigación.

Eso es emocionante y promete traer grandes beneficios , la mayoría de los cuales todavía tienen que ser imaginados. Pero también suscita preocupaciones. Inevitablemente, la gente teme que un AI lo suficientemente creativo como para sorprender a sus creadores pueda volverse maligno. De hecho, los modelos básicos están a años luz de los inteligentes robots asesinos amados por Hollywood. Los Terminators tienden a ser concentrados, obsesivos y ciegos a las consecuencias más amplias de sus acciones. El AI fundacional, por el contrario, es difuso. Del mismo modo, la gente está preocupada por las prodigiosas cantidades de energía que consumen estos modelos y las emisiones que producen. Sin embargo, los AIs son cada vez más eficientes, y sus conocimientos bien pueden ser esenciales para desarrollar la tecnología que acelera el cambio a la energía renovable.

Una preocupación más penetrante es quién controla los modelos de base. Entrenar un sistema realmente grande como PALM de Google cuesta más de $10 millones y requiere acceso a grandes cantidades de datos: cuanto más poder de cómputo y más datos, mejor. Esto plantea el espectro de una tecnología concentrada en manos de un pequeño número de empresas tecnológicas o gobiernos.

Si es así, los datos de entrenamiento podrían afianzar aún más los sesgos del mundo, y de una manera particularmente asfixiante y desagradable. ¿Confiarías en un niño de diez años cuyo sentido completo de la realidad se haya formado navegando en Internet? ¿se podrían reclutar AIs entrenados en China y Estados Unidos para una lucha ideológica para doblegar las mentes? ¿Qué pasará con las culturas que están mal representadas en línea?

Y luego está la cuestión del acceso. Por el momento, los modelos más grandes están restringidos, para evitar que se utilicen con fines nefastos, como generar noticias falsas. Open AI, una startup, ha diseñado su modelo, llamado DALL-E 2, en un intento por evitar que produzca imágenes violentas o pornográficas. Las empresas tienen razón al temer el abuso, pero cuanto más poderosos son estos modelos, más limitado el acceso a ellos crea una nueva élite. Es poco probable que la autorregulación resuelva el dilema.

Trae la revolución

Durante años se ha dicho que la automatización impulsada por inteligencia artificial representa una amenaza para las personas en trabajos repetitivos y rutinarios, y que los artistas, escritores y programadores estaban más seguros. Los modelos de base desafían esa suposición. Pero también muestran cómo se puede usar la inteligencia artificial como un compañero de software para mejorar la productividad. Esta inteligencia artificial no se parece a la humana, pero ofrece algo completamente diferente. Bien manejado, es más probable que complemente a la humanidad que usurparla. Lampadia