Mucho de lo que hemos publicado últimamente sobre la inteligencia artificial conlleva temores sobre el mal uso de esta tecnología para la raza humana. En el siguiente artículo de Luciano Floridi del Financial Times, el experto en filosofía y ética de la información descarta los temores como algo que no corresponde a lo que hoy se puede prever.

Los humanos no tienen nada que temer de las máquinas inteligentes

Luciano Floridi (Profesor de filosofía y ética de la información en la Universidad de Oxford, R.U.)

Financial Times

25 de enero 2016

Traducido y glosado por Lampadia

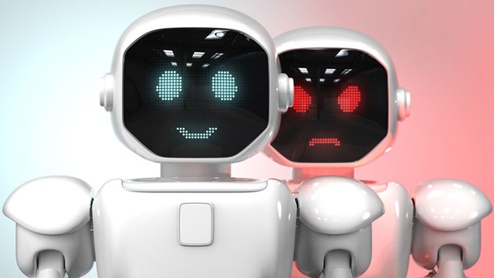

Ninguna versión de un Godzilla IA con está a punto de esclavizarnos.

Debemos centrarnos en los desafíos reales, dice Luciano Floridi.

Elon Musk, fundador de SpaceX y Tesla Motors, cree que la inteligencia artificial es «potencialmente más peligrosa que las armas nucleares». La «mayor amenaza existencial» para la humanidad, piensa, es una inteligencia de máquinas súper inteligencies estilo Terminator que un día dominarán a la humanidad. Por suerte, Musk se equivoca.

Muchas de las máquinas pueden hacer cosas increíbles, a menudo mejor que los humanos. Por ejemplo, la computadora Deep Blue de IBM jugó y venció al gran maestro Garry Kasparov en ajedrez en 1997. En 2011, otra máquina de IBM, Watson, ganó un episodio del programa de concurso de televisión Jeopardy, superando a dos jugadores humanos, uno de los cuales habían disfrutado de una racha de 74 victorias. El cielo, al parecer, es el límite.

Sin embargo, Deep Blue y Watson son versiones de la «máquina de Turing», un modelo matemático ideado por Alan Turing, que establece los límites de lo que un ordenador puede hacer. Una máquina de Turing no tiene entendimiento, no hay conciencia, no hay intuición – en fin, nada que reconoceríamos como una vida mental. Carece de la inteligencia incluso de un ratón.

Otros científicos están en desacuerdo. Stephen Hawking ha argumentado que «el desarrollo completo de la IA podría significar el fin de la raza humana».

Ray Kurzweil, inventor y futurista estadounidense de Silicon Valley, ha pronosticado que en 2045 el desarrollo de tecnologías de cómputo alcanzará un punto en el que la IA superará la capacidad del ser humano para comprenderla y controlarla. Escenarios como los de Kurzweil son extrapolaciones de la ley de Moore, según la cual el número de transistores en los ordenadores se duplica cada dos años, entregando más y más poder computacional a un costo cada vez menor.

Sin embargo, Gordon Moore, persona por la cual se nombró dicha ley, reconoció que es una generalización poco fiable porque hay un límite físico a la cantidad de transistores que pueden ponerse en un circuito integrado.

En todo caso, la Ley de Moore es una medida de la potencia de cálculo, no de inteligencia. Mi robot de limpieza, un Roomba, va a limpiar el suelo de forma rápida y barata y cada vez mejor, pero nunca va a reservar unas vacaciones por sí misma con mi tarjeta de crédito.

En 1950, Turing propuso la siguiente prueba: Imagine que un juez humano hace preguntas escritas a dos interlocutores en otra habitación. Uno de ellos es un ser humano, el otro una máquina. Si el juez no puede darse cuenta de la diferencia entre la máquina y el humano en el 70 por ciento de las veces, entonces, se puede decir que la máquina ha pasado la prueba.

Turing pensaba que las computadoras pasarían la prueba para el año 2000. Se equivocó. Eric Schmidt, el ex presidente ejecutivo de Google, cree que la prueba de Turing se logrará en 2018. Veremos. Hasta ahora no ha habido ningún progreso. Los programas de computadoras todavía tratan de engañar a los jueces mediante el uso de trucos desarrollados en la década de 1960.

Por ejemplo, en la edición 2015 del Premio Loebner, en un concurso anual de Turing, un juez le preguntó: «El auto no podía caber en el espacio de estacionamiento, ya que era demasiado pequeño. ¿Cuál era demasiado pequeño?» El software que ganó el premio de consolación de ese año respondió: «Yo no soy una enciclopedia andante, ¿sabes?»

Las ansiedades sobre máquinas súper-inteligentes son, por lo tanto, científicamente injustificadas. Las tecnologías «inteligentes» existentes no son un paso hacia la IA en toda marcha, al igual que subir a la cima de un árbol no es un paso hacia la luna, sino el final del viaje. Estas aplicaciones sin duda pueden ser más astutas que nosotros, pueden superarnos y sustituirnos en la realización de un número creciente de tareas. Esto no es porque tratan el mundo de forma inteligente, sino porque estamos volviendo al mundo cada vez más fácil para ellos.

Tome como ejemplo a los robots industriales. No les damos rienda suelta en el mundo para que construyan autos; construimos ambientes artificiales alrededor de ellos para asegurar su éxito. Lo mismo puede decirse de los miles de millones de artefactos inteligentes que pronto se comunicarán unos con otros vía la llamada ‘Internet de las Cosas’.

Ninguna versión Godzilla con IA de está a punto de esclavizarnos, por lo que debemos dejar de preocuparnos por la ciencia ficción y empezar a centrarnos en los retos reales que plantea la IA. En el análisis final, los seres humanos y no las máquinas inteligentes, son el problema, y lo seguirán siendo en el futuro previsible.

Nuestra prioridad debe ser evitar cometer errores dolorosos y costosos en el diseño y uso de nuestras tecnologías. Existe un grave riesgo de que podamos hacer un mal uso de ellas en detrimento tanto para la especie como para el planeta.

Winston Churchill dijo una vez: “nosotros damos forma a nuestros edificios y después nuestros edificios nos dan forma a nosotros.” Lo mismo se aplica a las tecnologías inteligentes en la ‘infoesfera’. Lampadia